অনেক ব্লগারই আছেন যারা Robots.txt অপশন ভালভাবে বুঝেন না কিংবা কখনো এ অপশনটি নিয়ে মাথা ঘামান না। তারা মনে করেন যে, এ অপশনটি কোন কাজের নয় বিাধয় এটি খালি রেখে দেন। সত্যি বলতে এ অপশনটি সার্চ ইঞ্জিন অপটিমাইজেশন করার জন্য খুবই গুরুত্বপূর্ণ ভূমিকা পালন করে। আর সার্চ ইঞ্জিন অপটিমাইজেশন না করে ব্লগিং চালিয়ে গেলে আপনার ব্লগে পর্যাপ্ত ভিজিটর পাওয়ার সম্ভাবনা কমে যায়। তবে এ অপশনটি একটিভ করতে গিয়ে আপনি যদি না বুঝেই অন্যের Robots.txt ফাইল কপি অপশনটি চালু করেন তাহলে ভাল না হয়ে এর বিপরীত হতে পারে। এই জন্য এটি একটিভ করার আগে আপনাকে এ সম্পর্কে বিস্তারিত জেনে নিতে হবে।

Robots.txt ফাইল কিঃ

প্রত্যেক সার্চ ইঞ্জিনেরই নিজস্ব ওয়েব রোবট রয়েছে। আপনি হয়তো ভাবছেন এটি কি রজনি কান্তের হিন্দি সিনেমার রোবটের মত। আসলে এটি এই ধরনের কিছু না। এটি হচ্ছে সার্চ ইঞ্জিনের যত প্রকার ওয়েবসাইট আছে তা পরীক্ষা করার জন্য এক ধরনের ওয়েব ফাংশন, যাকে রোবট নামে আখ্যায়িত করা হয়। আর Robots.txt ফাইল এর মাধ্যমে ঐ রোবটদের নির্দেশ করা হয় যে, আপনার ব্লগ/ওয়েবসাটটি সে Crawl এবং Index করবে কি না। আপনি ইচ্ছে করলে এই Robot.txt ফাইল ব্যবহার করে রোবটকে Crawl এবং Index করার অনুমতি দিতে পারেন আবার নাও দিতে পারেন। আবার আপনি ইচ্ছে করলে আপনার প্রয়োজনমত কিছু পোষ্ট Crawl এবং Index করার অনুমতি দিতে পারেন আবার কিছু পোষ্ট Crawl এবং Index করার অনুমতি নাও দিতে পারেন।কিভাবে এই Robots.txt ফাইল কাজ করে?

Robots.txt ফাইল হচ্ছে বিমান বন্দরের ফ্লাইট ঘোষকের মত। সে যে ভাবে ফ্লাইট হওয়ার সময় হলে যাত্রীদের যথাসময়ে বিমানের উঠার জন্য বলে দেয়, তেমনি Robots.txt ফাইলও সার্চ ইঞ্জিন গুলির রোবট যখন Crawl করার সময় হয়, তখন তার ব্লগের নতুন পোষ্ট গুলি Index করার কথা বলে দেয়। ফলে আপনার সদ্য পোষ্ট করা নতুন আর্টিকেল সহজে সার্চ ইঞ্জিনে চলে আসে।

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.prozokti.com/sitemap.xml

বেশীর ভাগ ব্লগ এর Robots.txt ফাইল এই ধরনের হয়ে থাকে। হয়তবা আপনিও কখনো না বুঝে আপনার ব্লগে ব্যবহার করেছেন কিংবা এখনো করছেন। আমি চাচ্ছি আপনি এ বিষয়ে পুরোপুরি বুঝে তারপরে এটি ব্লগে যুক্ত করেন। আমি এটিকে দুটি ভাগে ভাগ করে আলাদাভাবে বুঝানো চেষ্ট করবো। প্রথমে আমি এই অংশ গুলিকে নিয়ে এবং পরে এর মধ্যে যে সাংক্ষেতি চিহ্ন আছে সে গুলি নিয়ে আলোচনা করবো।

- User-agent: Mediapartners-Google: প্রথমত বলে রাখি User-agent এর মাধ্যমে রোবট সমূহ নির্দেশ করা হয়। এখানে Mediapartners-Google হচ্ছে Google Adsense এর একটি রোবট। আপনি যদি আপনার ব্লগে Google Adsense ব্যবহার করে থাকেন তাহলে এটি যুক্ত করতে হবে। যদি এই অপশনটি Disallow করে রাখেন তাহলে Adsense রোবট আপনার ব্লগের বিজ্ঞাপন সম্পর্কে কোন ধরনা পাবে না। আপনি যদি গুগল Adsense ব্যবহার করে না থাকেন, তাহলে এই লাল কালারের লাইন দুটি ডিলিট করে দেবেন।

- User-agent:* এর মাধমে সকল ধরনের রোবটদের বুঝানো হচ্ছে। আপনি যখন User-agent এর পরে * চিহ্নটি ব্যবহার করবেন তখনই বুঝাবে যে, আপনি সকল ধরনের রোবটদের নির্দেশ দিচ্ছেন।

- Disallow: /search এটি দিয়ে কিওয়ার্ডকে Disallow করার নির্দেশ দেওয়া হচ্ছে। অর্থাৎ আপনার ব্লগের Search লিংক গুলিকে Crawl এবং Index না করার জন্য বলা হচ্ছে। যেমন-আপনার ব্লগের Label লিংক গুলি দেখলে দেখতে পাবেন যে, প্রত্যেকটি Label এর লিংকের আগে এই Search শব্দটি আছে। এই জন্য Label লিংক গুলি Crawl না করার জন্য রোবটকে নির্দেশ দেওয়া হচ্ছে। কারণ Label লিংক গুলি সার্চ ইঞ্জিনে Index করানোর প্রয়োজন হয় না।

- Allow: / এটির মাধ্যমে কিওয়ার্ডকে Allow করার নির্দেশ দেওয়া হচ্ছে। এই '/' চিহ্নটির মানে হচ্ছে রোবট আপনার ব্লগের Home Page কে Crawl এবং Index করবে। যেমন-আপনি Google Webmaster Tools সাইট সাবমিট করার পর দেখতে পাবেন Google Webmaster Tools সবসময় আপনার পোষ্ট এর চাইতে একটি বেশী পোষ্ট Index করছে। আসলে বেশী নয়, এটি আপনার Home Page টিও গননা করছে।

- Sitemap: আপনি যখন নতুন পোষ্ট করবেন তখন এটি রোবটদের বলে দেবে নতুন পোষ্ট গুলি Index করার জন্য। পত্যেক ডিফল্ট ব্লগারের একটি Sitemap থাকে। কিন্তু ডিফল্টভাবে ২৫ টির বেশী পোষ্ট Index করে না। এই জন্য এই Sitemap লিংকটি Robots.txt ফাইলে যুক্ত করার পাশাপাশি Google Webmaster Tools এ সাবমিট করতে হয়।

আরো ভালভাবে বুঝতে চাইলে এটি পড়ুন| নাম | বর্ণনা |

|---|

| User-agent | এটি মাধ্যমে রোবট সমূহ নির্দেশ করা হয়। |

| Disallow | এটির মাধ্যমে বুঝানো হচ্ছে এর পরে যেই Directory থাকবে তা কোন রোবটই Crawl করবে না। নোটঃ Disallow এর পরে যদি কোন Directory না দেওয়া হয় তাহলে Disallow কাজ করবে Allow হিসেবে। |

| * | এই চিহ্ন দ্বারা সকল ধরনের রোবটদের বুঝানো হয়। |

| Allow | এটির মাধ্যমে বুঝানো হচ্ছে এর পরে যেই Directory থাকবে রোবট Crawl করবে। |

আরো ভালভাবে বুঝতে চাইলে এটি পড়ুন

| নাম | বর্ণনা |

|---|

| User-agent | এটি মাধ্যমে রোবট সমূহ নির্দেশ করা হয়। |

| Disallow | এটির মাধ্যমে বুঝানো হচ্ছে এর পরে যেই Directory থাকবে তা কোন রোবটই Crawl করবে না। নোটঃ Disallow এর পরে যদি কোন Directory না দেওয়া হয় তাহলে Disallow কাজ করবে Allow হিসেবে। |

| * | এই চিহ্ন দ্বারা সকল ধরনের রোবটদের বুঝানো হয়। |

| Allow | এটির মাধ্যমে বুঝানো হচ্ছে এর পরে যেই Directory থাকবে রোবট Crawl করবে। |

| নাম | বর্ণনা |

|---|

| User-agent | এটি মাধ্যমে রোবট সমূহ নির্দেশ করা হয়। |

| Disallow | এটির মাধ্যমে বুঝানো হচ্ছে এর পরে যেই Directory থাকবে তা কোন রোবটই Crawl করবে না। নোটঃ Disallow এর পরে যদি কোন Directory না দেওয়া হয় তাহলে Disallow কাজ করবে Allow হিসেবে। |

| * | এই চিহ্ন দ্বারা সকল ধরনের রোবটদের বুঝানো হয়। |

| Allow | এটির মাধ্যমে বুঝানো হচ্ছে এর পরে যেই Directory থাকবে রোবট Crawl করবে। |

কিভাবে ব্লগে যুক্ত করবেন?

- ব্লগার ড্যাশবোর্ড হতে Settings > Search Preference এ ক্লিক করুন।

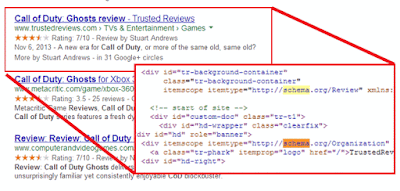

- তারপর Custom Robots.txt এর Edit বাটনে ক্লিক করুন। নিচের চিত্রে -

- এরপর Enable custom robots.txt conten এর Yes এ ক্লিক করলে একটি বক্স দেখতে পাবেন। এই বক্সে উপরের কোডগুলি কপি করে পেষ্ট করুন।

- তারপর Save এ ক্লিক করে বেরিয়ে আসুন। That's All.

লেখক:

লেখক: